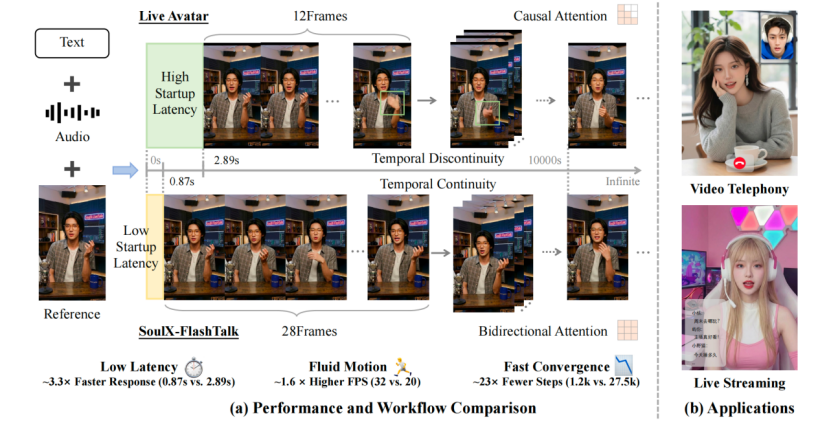

近期,Soul App AI 团队(Soul AI Lab)正式开源实时数字人生成模型 SoulX-FlashTalk,作为首个 14B 参数规模的数字人模型,它实现了 0.87s 亚秒级超低延时、32fps 高帧率的突破,更支持超长视频稳定生成,为行业带来了切实可落地的业务解决方案,推动大参数量实时生成式数字人迈入商用落地阶段。Soul 团队始终致力于通过技术创新打造更沉浸、多元的交互体验,此次开源的新模型在速度、效果、延迟和保真度上均表现出色,进一步夯实了其在 AI + 社交领域的技术优势。

在实时视频交互中,延迟是影响用户体验的关键因素。SoulX-FlashTalk 凭借全栈加速引擎的极致优化,将首帧视频输出延时降至 0.87s,让 14B 级大模型数字人首次具备即时反应能力,彻底消除了传统模型的 “滞后感”,无论是视频通话的即时对答、直播间弹幕的秒级互动,还是智能客服的实时响应,都能实现自然流畅的深度对话。同时,尽管搭载了 14B 参数量的超大 DiT 模型,其推理吞吐量仍高达 32FPS,远超直播所需的 25FPS 实时标准,证明了大参数模型经深度优化后可兼具高性能与高效率,让每一帧画面都丝滑顺畅。

针对数字人视频易出现的面部不一致、画质下降等问题,SoulX-FlashTalk 通过独家的自纠正双向蒸馏技术给出解决方案。其引入的多步回溯自纠正机制,能模拟长序列生成的误差传播并实时修正,如同为 AI 装上 “实时校准器”;而完全保留的双向注意力机制,让每一帧生成都能参考过去与隐含的未来上下文,从根本上压制身份漂移,确保超长直播中主播口型、面部细节和背景环境始终一致。此外,模型还突破了传统数字人仅能 “对口型” 的局限,支持音频驱动的全身动作生成,精准呈现结构清晰的手部动作细节,在保证动作灵活性的同时,维持了 99.22 的高身份一致性。

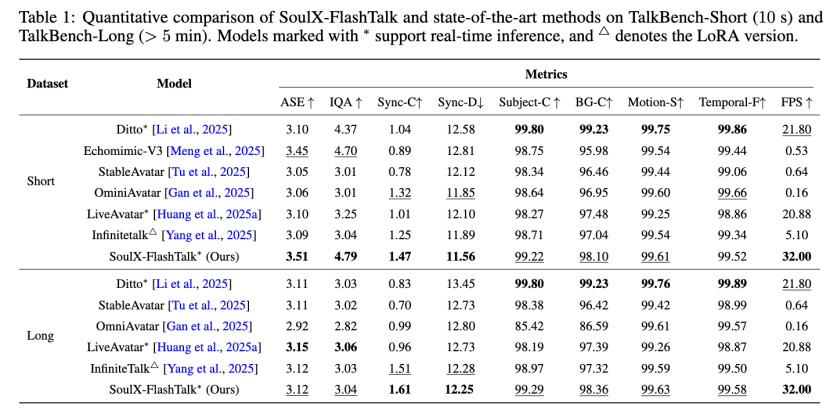

这些优势在性能测试中得到充分验证,在 TalkBench-Short 和 TalkBench-Long 数据集对比中,SoulX-FlashTalk 表现全面领先:短视频评测中以 3.51 的 ASE、4.79 的 IQA 刷新视觉保真度记录,1.47 的 Sync-C 分数实现最优口型同步;长视频生成中凭借双向蒸馏策略抑制同步漂移,Sync-C 达 1.61,且长短视频任务中均维持 32FPS 高吞吐量。依托这些性能,模型可广泛落地于多领域,如打造 7×24 小时 AI 电商直播间,解决传统数字人直播的画质模糊、口型错位问题,同时降低直播成本;在短视频制作、AI 教育、互动 NPC、智能客服等场景,也能提供高质量的解决方案。

值得一提的是,此次开源是 Soul AI 团队开源布局的延续,去年 10 月底开源的语音合成模型 SoulX-Podcast,曾登顶 HuggingFace TTS 趋势榜,目前 GitHub 星标超 3100 个。未来,Soul 将持续聚焦语音对话合成、视觉交互等核心能力提升,以开源为契机携手全球开发者共建生态,为“AI+社交”前沿能力建设注入新动力。

责任编辑:kj005

2月9日,灵璧县娄庄镇敬老院里欢声笑语不断,安徽腾原农业生态开发有限公司董事长胡修利带着满满心意返乡,将一整头猪、多份米面油等越冬物资送至老人手中,细心询问老人...

近期,Soul App AI 团队(Soul AI Lab)正式开源实时数字人生成模型 SoulX-FlashTalk,作为首个 14B 参数规模的数字人模型,...

2026 年 2月 6 日,由沈阳市数据局、中国信息通信研究院人工智能研究所、沈阳市数字经济企业协会及成都传媒(成都)有限公司共同主办的“2026年...